DỊCH VỤ

HẠ TẦNG GPU HIỆU NĂNG CAO

SẴN SÀNG ĐÁP ỨNG CHO MỌI MÔ HÌNH AI

Đăng ký ngay để trải nghiệm dùng thử miễn phí

GIỚI THIỆU

VNSO là đơn vị tiên phong chuyên cung cấp hạ tầng AI hiệu năng cao, từ GPU server thế hệ mới đến dịch vụ GPU Cloud chính hãng NVIDIA. Với sứ mệnh giúp doanh nghiệp khai thác tối đa sức mạnh AI, chúng tôi mang đến những sản phẩm và dịch vụ chất lượng quốc tế, chi phí hợp lý nhất đáp ứng hầu hết các yêu cầu của Doanh Nghiệp Việt Nam và khu vực.

-

Training Model

-

Inference Model

-

HPC (High Performance Computing)

-

Big Data & Analytics

-

AI Generative

-

AI as a Service

-

LLM (Large Language Models)

-

AI Agent

-

Rendering

LÝ DO LỰA CHỌN DỊCH VỤ

THUÊ SERVER GPU/AI, CLOUD GPU TẠI VNSO

Hiệu năng vượt trội với GPU thế hệ mới

VNSO trang bị các GPU NVIDIA mới nhất như: Ampere Gen3 A100 40GB/80GB, Hopper Gen4 H100 80GB, H200 141GB, Blackwell Gen5 B100, B200... giúp tối ưu cho các tác vụ AI, Machine Learning, Deep Learning, HPC, Rendering. Hỗ trợ kết nối NVLink, PCIe, SXM để truyền tải dữ liệu nhanh và ổn định.

Hàng stock sẵn, khởi tạo sau 30 Phút

Các sản phẩm VNSO luôn sẵn sàng tại Datacenter, chỉ cần kích hoạt là có thể sử dụng ngay trong vòng 30 phút. Giải pháp này giúp doanh nghiệp tiết kiệm thời gian, đảm bảo tiến độ dự án và nâng cao lợi thế cạnh tranh trong kỷ nguyên AI bùng nổ.

Đáp ứng mọi mô hình AI

Từ những mô hình AI đơn giản tới phức tạp, VNSO tự tin cung cấp cho Doanh Nghiệp các gói sản phẩm hạ tầng phù hợp nhất với các mô hình khác nhau: Deep Learning, Machine Leanring, LLM, GenAI, Edge AI, Hybrid Model

Linh hoạt cấu hình - Thanh toán theo giờ

Cho phép tăng/giảm GPU, CPU, RAM, Storage, Network... theo nhu cầu phát triển dự án trong từng giai đoạn. Chúng tôi cung cấp các gói dịch vụ theo giờ giúp tối ưu chi phí vận hành tối đa cho doanh nghiệp.

Bảo mật & an toàn dữ liệu

Áp dụng tiêu chuẩn bảo mật quốc tế, đảm bảo an toàn tuyệt đối cho dữ liệu & mô hình AI. Hạ tầng Datacenter đạt chuẩn Tier III với hệ thống nguồn điện ổn định, hệ thống làm mát chuyên dụng giúp đảm bảo máy chủ hoạt động ổn định. Ngoài ra VNSO cung cấp thêm hệ thống lưu trữ SAN Storage chuyên dụng giúp đảm bảo an toàn dữ liệu và bảo mật dữ liệu cho Doanh Nghiệp.

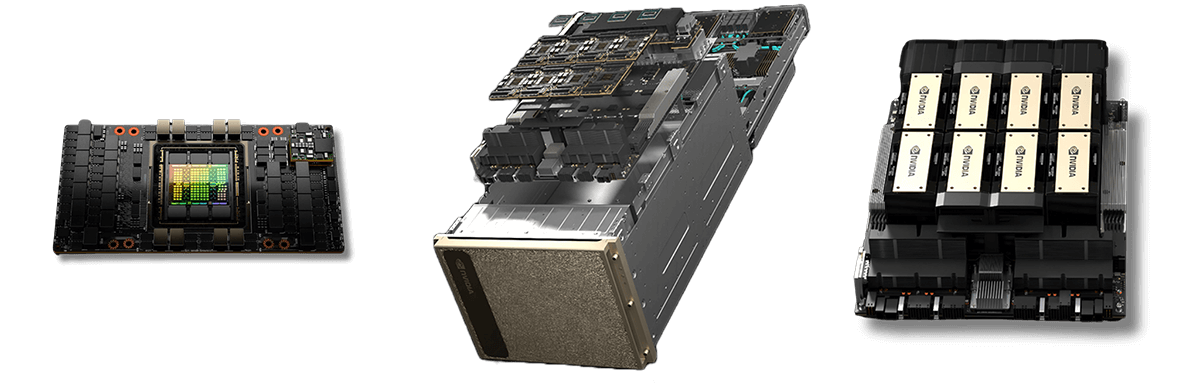

CÁC DÒNG GPU NVIDIA NỔI BẬT TẠI VNSO

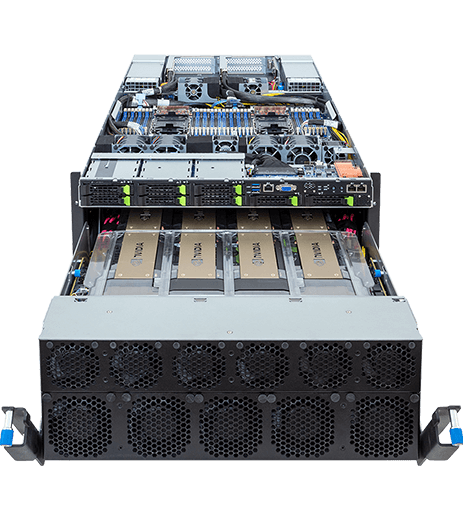

SIÊU MÁY CHỦ AI - NVIDIA DGX, HGX

SẴN SÀNG "LÊN MÂY"

- Các dòng đồ hoạ + AI: RTX (Server + Workstation): 3090, 4090, 5000, 5090, Blackwwell Pro 6000

- Các dòng chuyên về AI: V100, A10, A30, A40, A100, H100, H200, B100, B200 ...

- Siêu máy chủ: HGX 8 x A100 80GB SXM4, HGX 8 x H100 80GB SXM5, HGX 8 x A100 40GB SXM4

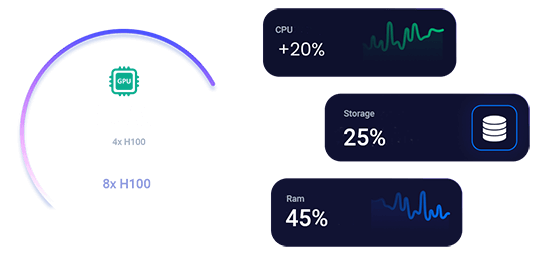

DỊCH VỤ CLOUD GPU

ĐƯỢC ẢO HOÁ TỪ HỆ THỐNG SIÊU MÁY CHỦ NVIDIA DGX/HGX CẤU HÌNH CAO

- CPU: 96 Core/132Threads CPU

- RAM: 1024 GB RAM DDR4/5

- Storage: 16TB NVMe SSD

- GPU: 8 x NVIDIA A100/H100 80GB SXM4/5

- Network: 10Gbps

Mang đến sự linh hoạt tối đa, giúp bạn hoàn toàn chủ động trong việc lựa chọn cấu hình và chi phí.

BẢNG GIÁ

DỊCH VỤ CLOUD GPU

LINH HOẠT CẤU HÌNH - LINH HOẠT THANH TOÁN - ĐÁP ỨNG MỌI YÊU CẦU

*Đặc biệt các gói sản phẩm Cloud GPU đều sử dụng Dedicated GPU, khách hàng không cần lo lắng về việc chia sẻ GPU khi sử dụng dịch vụ Cloud GPU tại VNSO.

A100 CLOUD - 40GB

Phù hợp với các doanh nghiệp bắt đầu triển khai chạy các mô hình AI quy mô vừa phải, hoặc chạy thử nghiệm thời gian đầu để đánh giá hiệu năng.

-

01 x GPU NVIDIA A100 40GB

-

Form Factor: SXM4

-

16Core/32T CPU

-

64GB DDR4 RAM

-

500GB NVMe SSD + 1TB SAN Storage

-

500Mbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

39.000 VNĐ /giờ

A100 CLOUD - 80GB

Phù hợp cho các doanh nghiệp có yêu cầu cao hơn, nguồn ngân sách thoải mái hơn mục đích rút ngắn thời gian training và inference cho mô hình AI

-

01 x GPU NVIDIA A100 80GB

-

Form Factor: SXM4

-

32Core/64T CPU

-

96GB DDR4 RAM

-

1TB NVMe SSD + 2TB SAN Storage

-

500Mbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

59.000 VNĐ

/giờH100 CLOUD - 80GB

Phù hợp cho doanh nghiệp có dữ liệu lớn, cần chạy nhiều mô hình/thuật toán nặng với tốc độ cao. Liên hệ chúng tôi để được tư vấn cấu hình tối ưu!

-

GPU NVIDIA H100 80GB (up to 8 GPUs)

-

Form Factor: SXM5

-

64Core/128T CPU

-

128GB DDR4 RAM

-

1TB NVMe SSD + 2TB SAN Storage

-

1Gbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

Liên hệ

A100 CLOUD - 40GB

Phù hợp với các doanh nghiệp bắt đầu triển khai chạy các mô hình AI quy mô vừa phải, hoặc chạy thử nghiệm thời gian đầu để đánh giá hiệu năng.

-

01 x GPU NVIDIA A100 40GB

-

Form Factor: SXM4

-

16Core/32T CPU

-

64GB DDR4 RAM

-

500GB NVMe SSD + 1TB SAN Storage

-

500Mbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

30.000 VNĐ /giờ

A100 CLOUD - 80GB

Phù hợp cho các doanh nghiệp có yêu cầu cao hơn, nguồn ngân sách thoải mái hơn mục đích rút ngắn thời gian training và inference cho mô hình AI

-

01 x GPU NVIDIA A100 80GB

-

Form Factor: SXM4

-

32Core/64T CPU

-

96GB DDR4 RAM

-

1TB NVMe SSD + 2TB SAN Storage

-

500Mbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

50.000 VNĐ

/giờH100 CLOUD - 80GB

Phù hợp cho doanh nghiệp có dữ liệu lớn, cần chạy nhiều mô hình/thuật toán nặng với tốc độ cao. Liên hệ chúng tôi để được tư vấn cấu hình tối ưu!

-

GPU NVIDIA A100 80GB (Up to 8GPUs)

-

Form Factor: SXM5

-

64Core/128T CPU

-

128GB DDR4 RAM

-

1TB NVMe SSD + 2TB SAN Storage

-

1Gbps/15Mbps Bandwidth

-

01 IP V4

-

Hỗ trợ NVLink + NVSwitch

Liên hệ

BẢNG GIÁ

DỊCH VỤ SERVER GPU

Dịch vụ thuê Server GPU hiệu năng cao dành cho các khách hàng muốn tự chủ động quản lý, sử dụng tài nguyên toàn bộ server (CPU, RAM, GPU, Network ...) đồng thời yêu cầu khắt khe về tính bảo mật dữ liệu. VNSO đề xuất các gói máy chủ kèm GPU để quý khách hàng tham khảo và đưa ra các lựa chọn phù hợp.

RTX 3090 24GB

- CPU: 2 x Intel Xeon E5 Series

- RAM: 32 GB

- Disk: 240GB SSD NVMe

- GPU: 01 x Nvidia RTX 3090

- Network: 200Mbps

RTX 4090 24GB

- CPU: 2 x Intel Xeon Gold Series

- RAM: 64 GB

- Disk: 240GB SSD NVMe

- GPU: 01 x Nvidia RTX 4090

- Network: 200Mbps

RTX 5880 48GB

- CPU: 2 x Intel Xeon Gold Series

- RAM: 64 GB

- Disk: 240GB SSD NVMe

- GPU: 01 x Nvidia RTX 5880

- Network: 200Mbps

RTX A5000 24GB

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 480GB SSD NVMe

- GPU: 01 x Nvidia RTX A5000

- Network: 200Mbps

Tesla V100 32GB

- CPU: 2 x Intel Xeon E5 Series

- RAM: 32 GB

- Disk: 240GB SSD NVMe

- GPU: 01 x Nvidia Tesla V100

- Network: 200Mbps

Ampere A30 24GB

- CPU: 2 x Intel Xeon Gold Series

- RAM: 64 GB

- Disk: 240GB SSD NVMe

- GPU: 01 x A30 Tensor Core

- Network: 200Mbps

Ampere A40 48GB

- CPU: 2 x Intel Xeon Gold Series

- RAM: 64 GB

- Disk: 480GB SSD NVMe

- GPU: 01 x Nvidia A40

- Network: 200Mbps

Blackwell Pro 6000

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 1024GB SSD NVMe

- GPU: 01 x Blackwell Pro 6000

- Network: 200Mbps

A100 40GB - PCIe

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 1TB SSD NVMe

- GPU: 01 x A100 40GB PCIe

- Network: 500Mbps

A100 80GB - PCIe

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 1TB SSD NVMe

- GPU: 01 x A100 80GB PCIe

- Network: 500Mbps

H100 80GB - PCIe

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 1TB SSD NVMe

- GPU: 01 x H100 80GB PCIe

- Network: 1Gbps

H200 141GB - PCIe

- CPU: 2 x Intel Xeon Gold Series

- RAM: 128 GB

- Disk: 1TB SSD NVMe

- GPU: 01 x H200 141GB PCIe

- Network: 1Gbps

FAQ

CÂU HỎI THƯỜNG GẶP

Những câu hỏi thường gặp đã được VNSO tổng hợp và giải đáp.

GPU NVIDIA H100 giới thiệu một số cải tiến quan trọng:

- - Lõi Tensor thế hệ thứ tư: Các lõi này vượt trội trong tính toán ma trận, nâng cao đáng kể hiệu quả của nhiều khối lượng công việc AI và HPC.

- - Transformer Engine: GPU H100 tích hợp Transformer Engine mới, mang lại những cải tiến đáng kể về tốc độ. Nó có thể đạt tốc độ đào tạo AI nhanh hơn tới 9 lần và tốc độ suy luận AI nhanh hơn tới 30 lần so với GPU A100 thế hệ trước, đặc biệt hữu ích cho các mô hình ngôn ngữ lớn.

- - Kết nối Mạng NVLink: GPU được trang bị kết nối Mạng NVLink mới, cho phép giao tiếp liền mạch giữa GPU với GPU. Nó có thể kết nối tối đa 256 GPU trên nhiều nút tính toán, tạo điều kiện trao đổi dữ liệu và xử lý song song hiệu quả.

- - Secure MIG (GPU Đa Phiên Bản): Secure MIG phân vùng GPU thành các phiên bản riêng biệt, tối ưu hóa Chất lượng Dịch vụ (QoS) cho khối lượng công việc nhỏ hơn. Điều này đảm bảo các tác vụ khác nhau chạy trên GPU không gây xung đột lẫn nhau, nâng cao hiệu suất và bảo mật tổng thể.

Việc triển khai mô hình AI/ML trên đám mây có thể là một quá trình phức tạp, nhưng với sự chuẩn bị cẩn thận, bạn có thể đảm bảo việc triển khai diễn ra suôn sẻ.

Sau đây là 10 cân nhắc chính giúp bạn chuẩn bị triển khai mô hình AI/ML trên đám mây:

- Chuẩn bị dữ liệu: Đảm bảo tập dữ liệu của bạn được chuẩn bị kỹ lưỡng, làm sạch và sẵn sàng sử dụng. Chất lượng dữ liệu là yếu tố quan trọng quyết định độ chính xác của mô hình.

- Triển khai mô hình: Phát triển và đào tạo mô hình AI/ML của bạn bằng các nền tảng phù hợp (ví dụ: TensorFlow, PyTorch, scikit-learn). Tối ưu hóa mô hình để sử dụng trong thực tế.

- Khả năng mở rộng và Lập kế hoạch Tài nguyên: Xác định tài nguyên tính toán bạn cần. Chúng tôi cung cấp nhiều tùy chọn GPU. Hãy cân nhắc các yêu cầu về khả năng mở rộng của bạn.

- Bảo mật: Triển khai các biện pháp bảo mật mạnh mẽ, bao gồm mã hóa, kiểm soát truy cập và xác thực để bảo vệ dữ liệu và mô hình của bạn.

- Container hóa: Container hóa mô hình của bạn bằng các công cụ như Docker. Container đảm bảo tính nhất quán trên các môi trường khác nhau.

- Kiến trúc vi dịch vụ: Hãy cân nhắc việc chia nhỏ ứng dụng của bạn thành các vi dịch vụ để có khả năng mở rộng và bảo trì tốt hơn.

- Cơ sở hạ tầng dưới dạng Mã (IaC): Sử dụng các công cụ IaC như Terraform để xác định cơ sở hạ tầng đám mây của bạn, đảm bảo tính nhất quán và quản lý dễ dàng.

- Giám sát và ghi nhật ký: Triển khai các giải pháp giám sát và ghi nhật ký để theo dõi hiệu suất mô hình, mức sử dụng tài nguyên và tình trạng hệ thống.

- CI/CD: Tạo quy trình CI/CD để tự động triển khai, thử nghiệm và cập nhật mô hình.

- Quản lý chi phí: Theo dõi và tối ưu hóa chi phí bằng cách sử dụng các công cụ vConsole và giá trả theo mức sử dụng.

Liên hệ

HÃY LIÊN HỆ VỚI CHÚNG TÔI

VNSO luôn sẵn sàng hỗ trợ Quý khách